研究进展

研究进展

吴宝昆/季晓慧:基于多标签图像分类的矿物识别研究【Minerals,2022】

2022-10-25 发布:[信息工程学院] 点击:722次

矿物鉴定在地质分析中不可缺少,传统矿物鉴定方法高度依赖专业知识和专用设备,这往往会带有较大的主观性并消耗大量的劳动力。为了增加客观性并减少鉴定人员的人力消耗,一些研究人员使用机器学习或深度学习的方法对图像中的矿物进行智能识别。但现有的智能识别方法只能识别图像中的单一矿物,而在自然环境中,矿物通常以共生或伴生的形式存在,这使得传统的智能识别方法无法胜任。

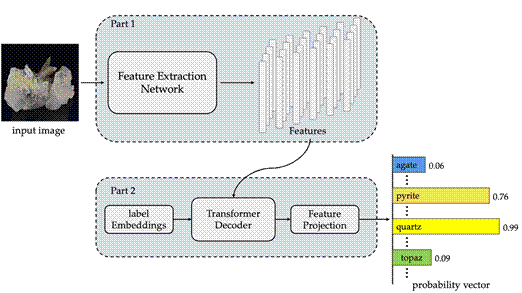

针对上述问题,我校信息工程学院硕士研究生吴宝昆在季晓慧副教授的指导下,提出了一种基于Vision Transformer和Transformer Decoder的共生或伴生矿物智能识别方法(图1),并在多标签矿物图像数据集上验证了方法的有效性。该工作的主要贡献如下:

(1) 首先利用基于self-attention结构的Vision Transformer(ViT-B/16)模型,对共生或伴生矿物图像的全局特征进行提取。识别结果显示,本文所使用的基于self-attention的ViT-B/16模型取得了较好的提取结果且可以大致定位已识别的矿物,整体识别的mean average precision为85.26%,比常用的特征提取网络ResNet101高了3.5%(表1),证明了所提方法的有效性。

(2) 利用Asymmetric Loss(ASL)损失函数,在训练过程中对模型进行性能评估监督优化,改善了多标签矿物图片数据集的标签不平衡问题。对比结果显示,本文所使用的ASL损失函数取得了较好的结果,整体识别的mean average precision相比于多标签常用的Binary Cross-Entropy损失函数提升了0.74%(表2)。

(3) 与目前不对矿物图像数据集做额外处理且表现最好的单标签矿物识别模型(将最后的输出层改为sigmoid)相比,本文的方法具有更好的性能(表3)。

图1. 基于Vision Transformer和Transformer Decoder的共生或伴生矿物智能识别方法

表1. 几种不同backbone对比

Backbone | mAP (%) | Number of Params (M) | Training Memory Cost (MB) |

MobileNet-V2 | 72.38 | 2.27 | 678.59 |

Big Transfer-m | 79.55 | 42.56 | 2002.74 |

ResNet-101 | 81.76 | 42.57 | 1527.08 |

ViT-B/16 | 85.26 | 85.67 | 1847.14 |

表2. 几种不同损失函数对比

Loss Function | mAP (%) | Parameter |

Binary Cross-Entropy | 84.52 | - |

Focal Loss | 84.79 | |

Asymmetric Loss | 85.26 |

表3. 与目前表现最好的单标签模型对比

Model | mAP (%) |

ResNet-50 + Feature Fusion | 72.13 |

ViT + Transformer Decoder (ours) | 85.26 |

上述研究成果发表在期刊《Minerals》

引用格式:Wu, B.; Ji, X.; He, M.; Yang, M.; Zhang, Z.; Chen, Y.; Wang, Y.; Zheng, X. Mineral Identification Based on Multi-Label Image Classification. Minerals 2022, 12, 1338. https://doi.org/10.3390/min12111338

全文链接:https://doi.org/10.3390/min12111338

返回学校首页

返回学校首页